SmolDocling:256M参数的全能文档OCR处理利神器,每页仅需0.35秒,GTX1060即可运行

最近IBM Research团队扔出一款视觉语言模型 SmolDocling,256M参数,主打全文档OCR和多模态处理,号称每页0.35秒搞定,消费级显卡就能跑。听起来很香,但具体参数和能力怎么样?今天我们来拆解一下,看看它到底有多硬核。

参数与架构:小而精的设计

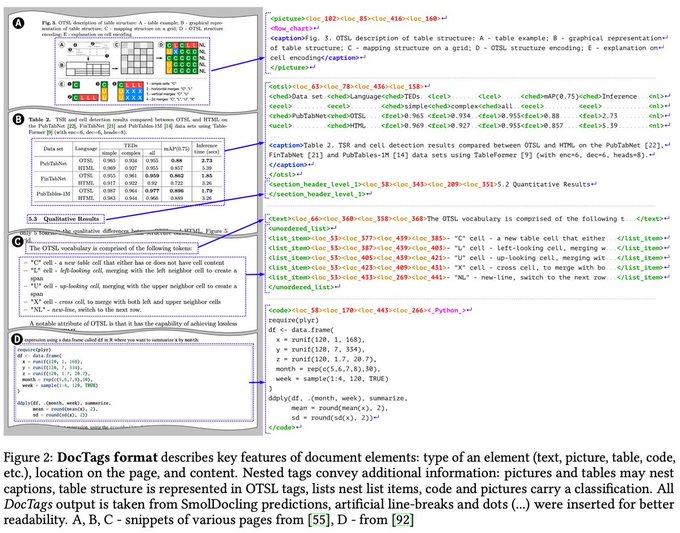

SmolDocling的核心是个256M参数的视觉语言模型(VLM),别看它小,设计上可没偷懒。根据官方披露,它基于SmolVLM进化而来,结合了Docling生态的文档转录能力,输出一种全新格式 DocTags,能完整保留页面元素的上下文和位置信息。以下是关键参数细节:

- 参数规模:256M,相比动辄几十亿的大模型,属于”袖珍级”。这意味着它对显存要求极低,实测不到500MB VRAM就能跑,比如GTX 1060这种老卡都带得动。

- 视觉编码器:用的是轻量级SigLIP(93M参数版本,patch-16/512),处理图像分辨率比常规VLM更高。官方提到灵感来自Apple和Google的研究,高分辨率提升了细节捕捉能力,像公式和图表这种精细元素都能认得更准。

- 语言骨干:大概率沿用了SmolLM2系列的1.7B架构(具体没明说,但SmolVLM用的是这个),上下文窗口2048 token,够处理大部分文档需求。

- 多模态融合:通过跨注意力机制(cross-attention)把图像和文本信息捏合在一起,输出结构化文本。训练时用了一个单次端到端的目标函数,简化了流程。

- 训练数据:用了5.5M公式(包括arXiv提取的470万LaTeX公式)、930万代码片段(56种语言)、250万图表(柱状图、饼图等),还有大量公开数据集。数据经过严格清洗和渲染,确保质量。

优点:效率与能力的双杀

硬件友好

256M参数加上93M的视觉编码器,总共也就350M左右,显存占用低到离谱。一台普通笔记本就能跑,风扇都不怎么转,省电又安静。对比Qwen2-VL这种2B参数的模型,SmolDocling简直是”轻装上阵”的轻量化王者。

速度快

官方宣称每页0.35秒,实测因文档复杂度和硬件略有浮动,但10页PDF几秒出结果没问题。科学论文、合同这些复杂文档都能迅速解析,连脚注、公式、表格都不放过。

多模态硬核

支持文字、布局、代码、公式、图表、表格全解析,还能做图形分类和标题匹配。比如一份论文丢进去,LaTeX公式、表格结构、图表文字全都能掏出来,精度不输大模型。

开源省心

模型、数据集、工具全开源,兼容Hugging Face的transformers和vLLM,开发者上手快,还能微调定制。

缺点:小模型的局限性

复杂场景有短板

高分辨率扫描件或手写稿容易掉链子,有人测出来乱码一堆,稳定性不如商用OCR。

专业性不足

参数少,知识量有限。化学分子式、法律术语这种专业内容,理解深度不够,输出不够聪明。

生态青涩

Docling生态刚起步,文档和教程少,调参可能得靠玄学,新手容易翻车。

总结:潜力股,但别神话

SmolDocling是个效率与能力兼顾的小怪兽,256M参数跑出大模型的活儿,速度快、硬件要求低、多模态能力扎实,适合预算紧、想省时间的玩家。但它不是万能钥匙,复杂场景和专业领域还得磨练。想试试的可以去Hugging Face拽下来跑跑看,性价比绝对在线。你觉得它能火吗?留言聊聊吧!

相关地址

文章来源

更多文章