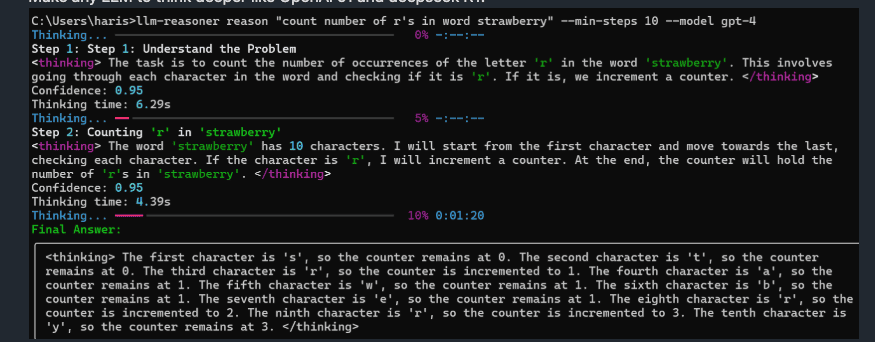

LLM-Reasoner:让你的大语言模型像DeepSeek R1一样深度思考

6 min read

简介

在AI领域,大型语言模型(LLM)正变得越来越复杂,像DeepSeek R1这样的模型展示了先进的推理能力。如果你想提升你的LLM的推理过程,使其与这些复杂模型相匹配或模仿,那么LLM-Reasoner 就是你需要的工具。这个工具允许任何LLM进行逐步推理,展示了如何得出结论,就像DeepSeek R1那样透明。

LLM-Reasoner的独特之处

- 逐步推理:与传统的LLM不同,这些模型可能会直接给出答案而不解释过程,LLM-Reasoner将复杂的问题分解成可理解的推理步骤,提供了决策的透明度。

- 实时进度动画:可以实时观察推理过程的演变,不仅信息丰富,还很引人入胜。

- 多供应商兼容性:通过与LiteLLM的整合,LLM-Reasoner支持多种LLM提供商,增强了灵活性。

- 用户友好的界面:基于Streamlit的UI便于交互,同时提供命令行接口(CLI)供编写脚本的用户使用。

- 信心跟踪:每个推理步骤都附带信心得分,让用户了解模型的确定性。

快速开始

1. 安装

pip install llm-reasoner2. 配置API密钥

# OpenAI

export OPENAI_API_KEY="sk-your-key"

# Anthropic

export ANTHROPIC_API_KEY="your-key"

# Google Vertex

export VERTEX_PROJECT="your-project"3. 基本命令

# 查看可用模型

llm-reasoner models

# 对查询进行推理

llm-reasoner reason "飞机如何飞行?" --min-steps 5 # min-steps: 最少推理步骤数,确保推理过程足够深入

# 启动交互式UI

llm-reasoner ui主要参数说明:

min-steps:设置最少推理步骤数,范围1-10,默认为3。数值越大,推理过程越详细max-steps:设置最大推理步骤数,范围2-20,默认为8。防止推理过程过于冗长temperature:控制输出的随机性,范围0-2,默认0.7。值越低,输出越确定性timeout:推理超时时间(秒),默认30秒。可根据问题复杂度调整

SDK使用指南

基础示例

from llm_reasoner import ReasonChain

import asyncio

async def main():

# 创建推理链实例,配置核心参数

chain = ReasonChain(

model="gpt-4", # 使用的模型,支持各大主流LLM

min_steps=3, # 最少推理步骤数,确保推理深度

temperature=0.2, # 温度参数,控制输出随机性

timeout=30.0 # 推理超时时间,单位秒

)

# 异步生成推理步骤,包含丰富的元数据

async for step in chain.generate_with_metadata("天空为什么是蓝色的?"):

print(f"步骤 {step.number}: {step.title}")

print(f"思考时间: {step.thinking_time:.2f}秒") # 每步耗时

print(f"置信分数: {step.confidence:.2f}") # 模型对该步骤的确信度

print(step.content) # 推理内容

asyncio.run(main())返回的step对象包含以下重要属性:

number:当前是第几步推理title:该步骤的标题概述thinking_time:该步骤的思考时间confidence:模型对该步骤结论的信心程度(0-1)content:详细的推理内容

高级功能

元数据追踪

每个推理步骤包括信心水平和处理时间等元数据,允许更深入的分析。

自定义模型注册

# Python API

from llm_reasoner import model_registry

model_registry.register_model(name="我的模型", provider="我的供应商", context_window=8192)# CLI方式

llm-reasoner register-model 我的模型 azure --context-window 16384推理链定制

chain = ReasonChain(

model="claude-2", # 选择要使用的模型

max_tokens=750, # 单次推理最大token数,影响输出长度

temperature=0.2, # 温度参数:0-2之间,越低输出越确定

timeout=30.0, # 推理超时时间:建议根据问题复杂度设置

min_steps=5 # 最少推理步骤:确保推理过程足够深入

)

chain.clear_history() # 清除历史记录,开始新的推理会话核心参数说明:

model:使用的模型名称,需要确保已配置对应的API密钥max_tokens:控制每步推理的最大输出长度,建议300-1000之间temperature:值越低,输出越稳定可预测;值越高,输出越有创造性timeout:单位为秒,复杂问题建议适当增加min_steps:强制模型进行更细致的推理,但会增加API调用成本

模型支持

LLM-Reasoner支持来自以下提供商的模型:

- OpenAI

- Anthropic

- Azure

- 自定义模型

UI使用指南

- 启动UI界面:

llm-reasoner ui- 在界面中:

- 选择合适的模型

- 调整相关设置

- 输入查询问题

- 观察推理过程的实时展开

注意事项

- 项目依赖 litellm 提供llm的模型和api,因此具体模型和提供商要看 litellm 官方文档

- 本地调试注意设置对应llm提供商的环境变量

更多文章

Qwen3-Next 系列全解析:80B-A3B 的混合架构,Instruct 与 Thinking 双线能力进化

DeepSeek V3.1:混合推理、强劲编程与 Agent 能力,支持Claude Code,性价比再升级

Qwen-Image-Edit 图像编辑介绍与 ComfyUI 使用指南

沉浸式翻译插件重大安全漏洞:网页快照功能导致用户敏感信息大规模泄露

GLM-4.5技术报告与应用体验:国产智能体大模型新标杆

Win11Debloat 深度指南:一键精简 Windows 11,告别臃肿,提升系统性能

阿里Qwen-MT翻译模型重磅升级:92种语言、秒级响应,挑战GPT-4翻译霸主地位

Kimi K2如何凭借三大创新炼成万亿开源模型?

Docker运行macOS教程:Linux系统完整配置与部署指南