Meta重磅发布Llama 3.3:70B参数媲美405B,支持128K超长上下文

3 min read

Meta于12月6日重磅发布新一代开源大语言模型Llama 3.3,在模型性能、多语言能力和上下文长度等方面实现重大突破。

核心亮点

相比前代产品,Llama 3.3在以下方面取得显著进展:

- 超强性能:仅用70B参数即可达到405B级别的模型性能

- 超长上下文:支持128K tokens的上下文窗口,大幅提升长文本处理能力

- 多语言支持:原生支持8种语言,包括英语、德语、法语等主流语言

- 高效架构:采用优化的Transformer架构,配备GQA注意力机制

技术规格

Llama 3.3的主要技术参数:

- 预训练数据:15T+ tokens的公开在线数据

- 知识截止:2023年12月

- 输入输出:支持多语言文本输入,可输出文本和代码

- 训练方式:结合SFT和RLHF进行指令调优

- 部署要求:支持4-bit和8-bit量化部署

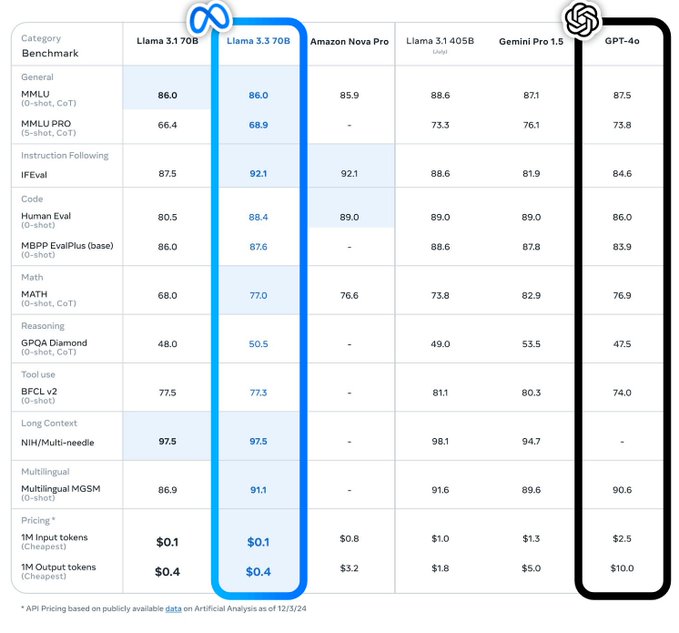

性能评测

在多个权威基准测试中,Llama 3.3展现出卓越性能:

- MMLU(CoT):86.0分提升至88.6分

- HumanEval:80.5%提升至88.4%

- MATH(CoT):68.0分提升至77.0分

- MGSM:86.9%提升至91.1%

开源策略

Meta采取负责任的开源策略:

- 提供完整模型权重和代码

- 开放社区许可协议

- 支持商业和研究用途

- 内置多重安全保障机制

使用限制

使用Llama 3.3需注意以下事项:

- 需同意Meta隐私政策

- 遵守社区使用准则

- 商用需额外授权

- 禁止用于非法用途

Meta表示,Llama 3.3的发布将加速AI民主化进程,为全球开发者和研究者提供更强大的开源选择。

获取模型

模型已在Hugging Face平台开放下载:@meta-llama/Llama-3.3-70B-Instruct

注意:下载和使用模型需要同意Meta的使用条款和隐私政策。

更多文章

Qwen3-Next 系列全解析:80B-A3B 的混合架构,Instruct 与 Thinking 双线能力进化

DeepSeek V3.1:混合推理、强劲编程与 Agent 能力,支持Claude Code,性价比再升级

Qwen-Image-Edit 图像编辑介绍与 ComfyUI 使用指南

沉浸式翻译插件重大安全漏洞:网页快照功能导致用户敏感信息大规模泄露

GLM-4.5技术报告与应用体验:国产智能体大模型新标杆

Win11Debloat 深度指南:一键精简 Windows 11,告别臃肿,提升系统性能

阿里Qwen-MT翻译模型重磅升级:92种语言、秒级响应,挑战GPT-4翻译霸主地位

Kimi K2如何凭借三大创新炼成万亿开源模型?

Docker运行macOS教程:Linux系统完整配置与部署指南

相关文章

暂无相关文章